根据世界经济论坛的估算,2020年全世界产生了超过44ZB的数据量,而在十年前全球的数据总量还只有1ZB。

数据量的指数级增长,预示着人类文明彻底进入了数字化时代,数据已经成为人类存在的另一种方式。特别是在新基建、数字经济等宏观话题大行其道的当下,数据的存储、挖掘、应用早已和经济直接挂钩。

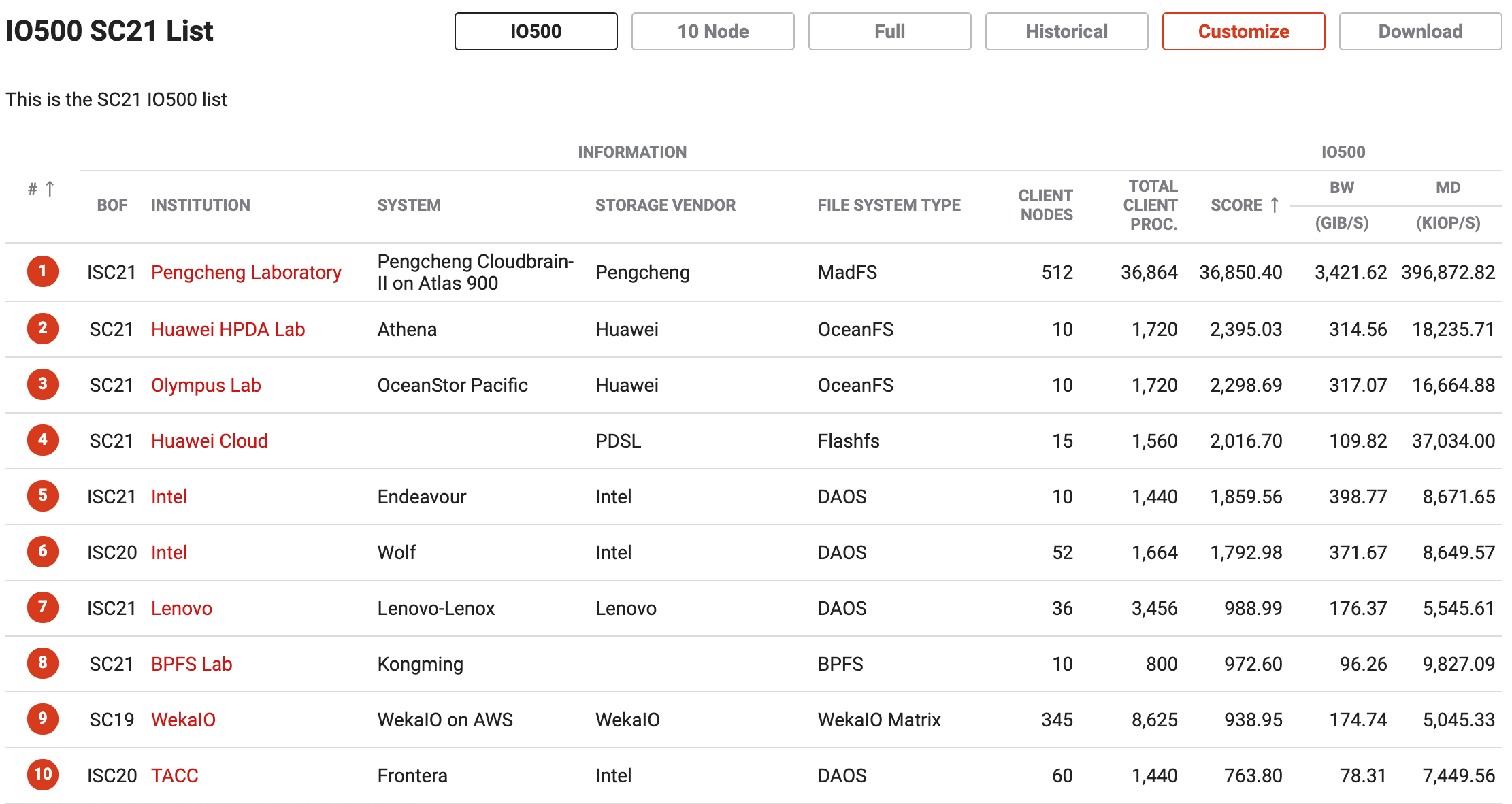

11月18日的国际超级计算大会SC21上,正式公布了最新的全球IO500榜单。其中华为OceanStor Pacific存储在IO500榜单和10节点榜单中均名列第二,刷新了华为覇榜IO500的新纪元。

作为存储性能最权威的世界排行榜之一,IO500包括总榜单和10节点榜单两大类别。由于10节点榜单将基准性能测试限制为10个计算节点,可以准确反应存储系统为实际程序提供的I/O性能,被视为衡量超级计算机应用效率的核心指标。

当华为OceanStor Pacific代表的企业占领IO500榜单的头部,乃至将榜单前三名均收入囊中的时候,对整个存储市场意味着什么?

01 高性能计算三部曲

想要理解数据存储性能的价值所在,似乎有必要回顾下高性能计算(HPC)的进化历程。毕竟在人类从工业文明迈向信息文明的过程中,HPC扮演了不可或缺的角色,甚至说是科技创新的典型标杆。

以往在复盘HPC进化史的时候,不少人习惯按照时间轴进行整理,直观地展现算力上的爆炸性增长。倘若从需求驱动的思路审视HPC的发展史,或许可以找到一个新的视角,即应用需求深度影响了HPC的进化方向。

最早的“超级计算机”属于政府主导的项目,第一台电子计算机ENIAC的诞生为起点,HPC在长达几十年的时间里被应用于高能物理、流体力学等学术领域,数值计算的场景决定了HPC不断提升计算能力的演变轨迹。

随着越来越多的商业公司进入到计算产业,HPC的应用场景逐步向油气勘探、气象预测、芯片研发等领域倾斜,模拟仿真的需求渐渐超过了数值计算,HPC的进化不再只是主攻算力,而是存储、网络等多元化的性能。

到了2020年前后,自动驾驶、基因测序、深空探索等商业智能蓬勃向上,HPC的应用场景也进一步转变:需要卷积更多的历史数据参与计算分析,不断提升分析的精度,对数据存储的性能需求逐渐上升到了新的高度。

正是在这样的大背景下,John Bent、Julian Kunkel、Jay Lofstead在内的学者纷纷推动IO性能的测试方法、基准测试程序和规则,通过模拟应用需要的不同IO模型,验证数据带宽(GIB/s)和元数据(KIOP/S)两个关键维度的性能表现,并在一些TOP500计算机上进行了测试。

2017年的国际超级计算大会上,VI4IO组织公布了第一份IO500榜单,约定每年在SC和ISC大会上各更新一次排名。

IO500榜单的出现就像是一道江湖集结令,拉开了各路英雄角逐存储性能的序幕:新兴存储硬件层出不穷,新兴文件系统应运而生,标准和架构也不断推陈出新,数据存储进入了群雄逐鹿的年代。

毕竟HPC领域的所有玩家都明白一个道理:现实中许多场景参与计算的数据量已经达到了PB级,计算过程中需要频繁进行访存操作,存储性能直接影响着计算的效率,同时对数据可靠性和安全性的要求也越来越高。数据存储性能预料之中的成了高性能计算的聚焦点,也是各大厂商的必争之地。

02 HPDA的产业态势

为何IO500榜单有这么大的魔力?答案还要从需求的变化说起。就像在HPC的进化历程中,一个明显的态势是从“以计算为中心”到“以数据为中心”的转变,进入到了“数据密集型”的新阶段。

国际权威分析师机构Hyperion Research,曾在2020年对全球HPC市场的增速做出预测:2019年到2024年的时间周期内,存储市场的复合增长率有望达到12.1%,远高于服务器、中间件、应用、服务等市场。

之所以给出这样的判断,离不开一个特定的产业共识:在自动驾驶、气象预测、宇宙探索等热门的应用场景中,HPC和AI、大数据的融合越来越紧密,HPC向HPDA(数据密集型超算)的演进,屡屡成为行业论坛上的主流议题。

可以找到的例子有很多。

过去地震勘探是二维的,从二维到三维的演进中,采集和处理的数据量增加了5—10倍;电影渲染逐渐从2K向4K乃至8K过渡,对应的数据量增加了16倍;卫星测绘领域的精度从20米缩小到2米,数据量同比增长了70倍……再加上数据分析处理的算法越来越复杂,采集、存储、处理、存档的数据量呈现出爆炸式增长。

然而传统的HPC存储主要用于建模和仿真,包括项目文件共享、搜索、归档等等,主要是结构化的数据,且通常是基于顺序的大I/O型。但人工智能的工作流程涉及到数据收集、注入、训练、推理和归档,不仅涵盖结构化和非结构化的数据,数据存取的场景也更加复杂,AI负载需要顺序大I/O型和随机小I/O型的组合,特别是AI数据集标注的元数据管理,需要快速的随机小I/O型。

也就是说,推动数据存储性能不断提升的因素,绝不只是IO500榜单,而是隐藏在榜单背后的市场需求。传统HPC的数据存储已经跟不上需求,能否打破数据存储、性能、效率的限制,已经是HPC产业革新的掣肘因素。

按照Hyperion Research在《HPDA趋势白皮书》中的建议,针对HPDA负载中经常出现的非结构化数据,数据存储应该进行针对性的创新,包括支持不同的I/O模型、支持多协议访问、支持各种数据访问频率、高密度高效设计等等,不断提升数据利用率,进一步释放数据潜力。

恰恰是数据存储的新一轮革命,为华为等企业提供了重拾话语权的机会,并趁机进行直线超车。

03 华为越级的硬实力

也就解释了文初的一幕:几年前的IO500榜单还被Intel、DDN、IBM等企业占领,当HPC向HPDA演进的时候,华为OceanStor Pacific等新势力频频出现,而且就拿到了让人振奋的位次。

如同中国超算力量的强势崛起,华为OceanStor Pacific斩获IO500榜单全球第二的消息并不令人意外。在这场技术硬实力的较量中,华为OceanStor Pacific的“越级”离不开4000多位研发人员夜以继日的努力,以及3000多项专利构成的技术创新,打破了HPC产业的三重壁垒:

一是多业务混合负载能力。传统HPC存储只支持单一负载,形成了性能上的孤岛,导致流程间的数据需要在不同存储间迁移,可以说是效率降低的“元凶”。

华为OceanStor Pacific存储搭载了新一代并行文件系统,针对传统HPC的问题进行了对症下药:采用目录DHT分区、大IO直通小IO聚合、多粒度磁盘空间管理列技术,一套存储同时实现了大文件高带宽、小文件高IOPS,配合分布式并行客户端技术,轻松满足了客户对多业务混合负载的需求。

二是多协议无损互通方案。在数据处理过程中,多样性的数据转化、拷贝、加载等环节就占据了35%以上的时间,人为制造了阻碍效率升维的格式壁垒。

华为OceanStor Pacific的切入点是协议互通,通过统一的数据管理系统和硬件资源池,文件、对象、大数据客户端可以同时读写同一个文件,不需要协议转换的过程,让数据分析的效率提升了30%以上,并且避免了数据拷贝产生的冗余副本,节省了端到端的存储资源,让硬件发挥出极限性能。

三是超高密设计的硬件。当海量数据的价值被进一步分析挖掘,就需要保留更多更长久的数据资源,对机房空间、功耗、存储成本等都提出了新的挑战。

为了解决这些“痒点”,华为OceanStor Pacific推出了系列化超高密硬件,支持不同硬件间的数据自动分级,全面降低了HPC场景的存储成本。以华为OceanStor Pacific 9950为例,每个5U机箱可容纳8个存储节点,提供128TB至614.4TB裸容量,节省了60%以上的机柜空间和能耗。

可以看到,华为OceanStor Pacific的软硬件创新,填补了HPC向HPDA转型的数据存储短板,无形中为HPDA进程按下了“快进键”,也为站在转型节点上的企业,提供了迎合数据密集型趋势的“理想之选”。

04 写在最后

衡量一款产品、一家企业的价值标杆,绝非是这样或那样的榜单,倘若只是静静地躺在榜单上,再好的结果也没有太大的意义。尽管是IO500榜单上一鸣惊人的新秀,但华为OceanStor存储并不让人陌生。

中石化物探研究院采用华为OceanStor存储的服务,降低了30%的数据存储成本,勘探效率提升了16%,运维管理成本降低了50%;上海天文台在华为OceanStor存储的帮助下,搭建了世界首台SKA原型机,性能较传统存储提升了10倍;华大基因将华为OceanStor存储用于无创产前基因检测业务模型中,数据存储性能提升了30%左右,基因检测报告从15天压缩到了7天……

相较于那些为了冲榜而送测的企业,华为OceanStor Pacific正在以一种润物细无声的方式渗透进社会生活的方方面面,帮助千行百业解决数据密集型升级带来的挑战,IO500榜单第二的殊荣不过是水到渠成的结果。

华为,数据,榜单,数据存储,性能